Veröffentlicht am:

Vom Finanzsektor über das Energiemanagement bis zur Logistik sind Zeitreihenprognosen eine der zentralen Methoden zur Vorhersage zukünftiger Ereignisse und Entwicklungen.

Üblicherweise benötigen Modelle zur Prognose von Zeitreihen, wie unter anderem klassische Machine-Learning-Methoden wie XGBoost oder neuronale Netze wie Temporal Fusion Transformers (TFT) umfangreiche Trainingsdaten von der gleichen Zeitreihe oder zumindest aus der gleichen Domäne (Fine-Tuning). Oftmals liegen diese jedoch nicht vor – das sogenannte Kaltstart-Problem. Inspiriert von Entwicklungen im Bereich Natural Language Processing entsteht der Wunsch nach einheitlichen, allgemein anwendbaren und anpassbaren Vorhersagemodellen. Solche sogenannten Foundation Models sind insbesondere durch Large Language Models (LLMs) wie ChatGPT in den letzten Jahren bekannt geworden und haben kürzlich nun auch in der Zeitreihenprognose Anwendung gefunden. Anhand der Auswertung mehrerer Modelle in einem konkreten Anwendungsszenario wird im Folgenden dargestellt, wie Foundation Models als Tool dienen können, um ad-hoc präzise Zeitreihenprognosen zu erhalten und welche Aspekte dabei zu beachten sind.

Zero-Shot Zeitreihenprognosen mit Foundation Models

Foundation Models sind typischerweise auf neuronalen Netzwerken basierende Machine-Learning-Modelle, welche mithilfe umfangreicher Datenmengen trainiert werden. Diese Modelle eröffnen neue Möglichkeiten für Zero-Shot-Zeitreihenprognosen. Hierbei bezieht sich Zero-Shot Learning auf die Fähigkeit eines Modells, eine Vorhersage für eine Zeitreihe zu treffen, ohne explizit auf Beispielen dieser Zeitreihe trainiert worden zu sein. Dabei erlernen sie Repräsentationen der Zeitreihendaten, welche zugrundeliegende Merkmale und Muster erfassen und auf verschiedene nachgelagerte Aufgaben, einschließlich der Zeitreihenprognose, übertragen werden können.

Aktuelle Entwicklungen in Foundation Models für Zeitreihenprognosen

Einen besonderen Beitrag zu Foundation Models für Zeitreihenprognosen stellten Gruver et al. 2023 auf der NeurIPS-Konferenz, einer der wichtigsten KI-Konferenzen, vor. Sie zeigten, wie große Sprachmodelle wie GPT-3 oder LLaMa für Vorhersagen genutzt werden können. Wie natürliche Sprache für ein statistisches Modell verarbeitbar dargestellt werden kann, haben wir in diesem Blogartikel zum Thema RAG ausführlich beschrieben.

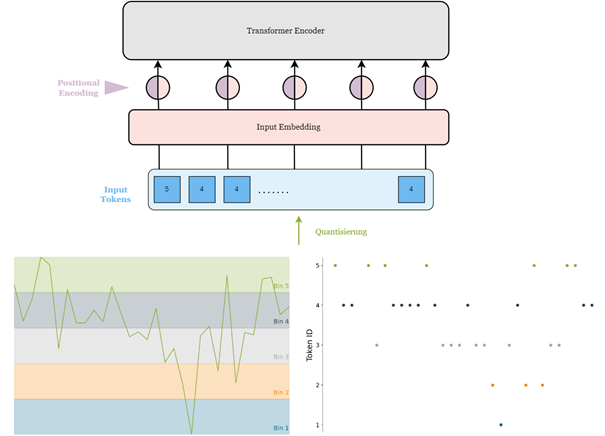

Abb. 1.1: Verarbeitung der Zeitreihendaten durch „Horizontales Binning“: Zeitreihen werden durch Skalierung und anschließendes Binning in diskrete Werte umgewandelt. Beim Binning werden die beobachteten Werte der Zeitreihe auf eine vordefinierte Menge gleichmäßiger Intervalle abgebildet.

Die Indizes der Intervalle dienen als Tokens und können von Transformer Modellen analog wie bei Sprachmodellen verarbeitet werden.

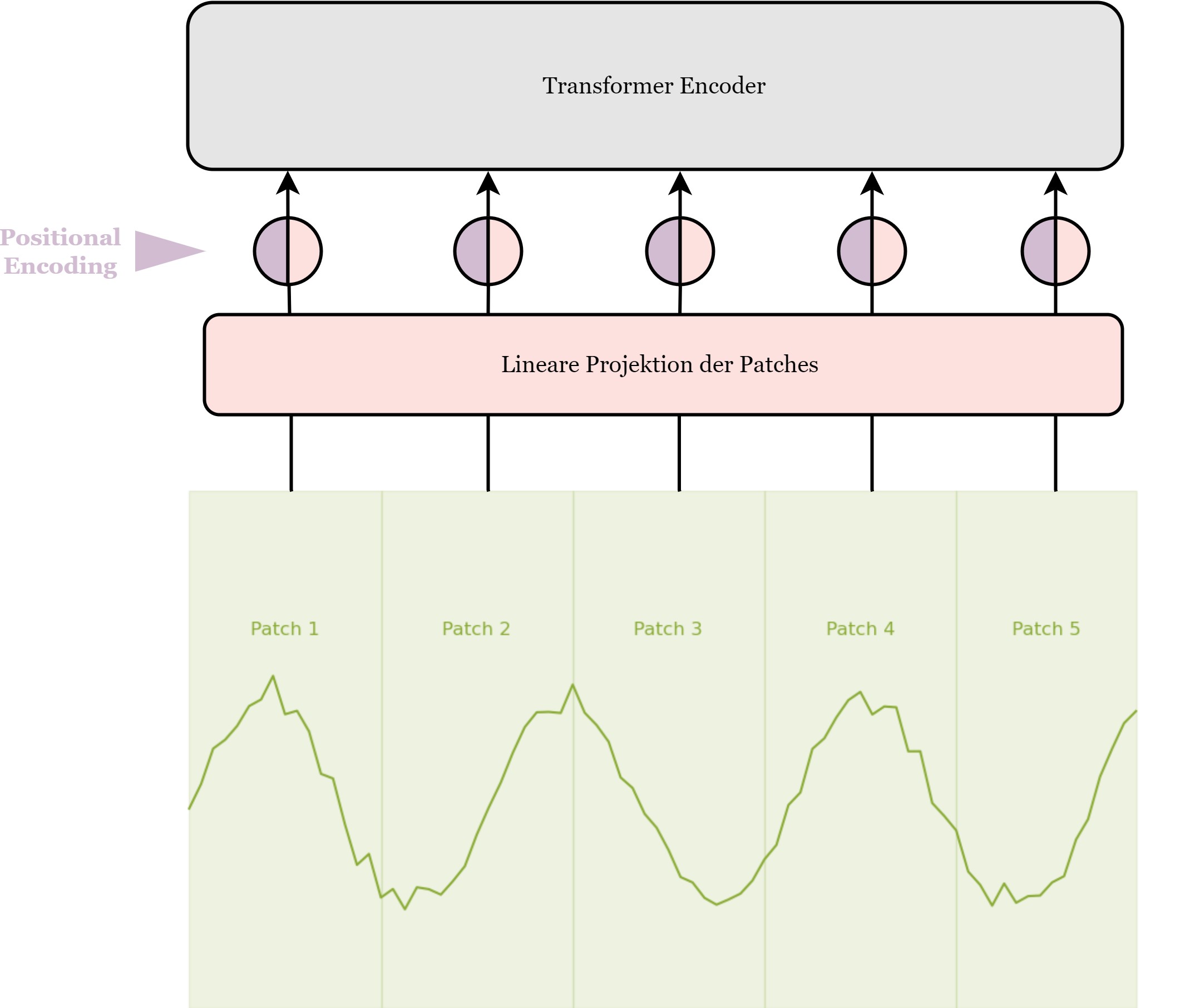

Abb. 1.2 Verarbeitung der Zeitreihendaten durch „Vertikales Binning”: Diese Modelle zerlegen Zeitreihen in Patches, die in vektorisierter Form als Patch Embeddings vom zugrunde liegenden Transformer-Modell genutzt werden.

Die Aufteilung kann man sich hier anschaulich als vertikale Klassen (engl. bins) merken, analog zu den horizontalen Klassen bei Chronos.

Ein wichtiger Schritt hin zu von Grund auf für Zeitreihen trainierten Foundation Models wurde bereits 2022 ermöglicht, als Nie et al. zeigten, dass durch das Zusammenfassen mehrerer Zeitschritte zu “Patches” die Performance damaliger Transformer-Modelle verbessert werden kann. Viele der heutigen Foundation Models bauen auf diesem Ansatz auf. Abbildung 1.2 illustriert diesen Verarbeitungsprozess. Andere Modelle teilen die Werte der Zeitreihe in Wertebereiche ein, analog zu Token in reinen Sprachmodellen (siehe Abb. 1.1). Eines der ersten gezielt für Zeitreihenprognosen entwickelten Foundation Models erschien 2023 mit TimeGPT, welches laut Autoren auf über 100 Milliarden Datenpunkten trainiert wurde. Seitdem wurden einige weitere Modelle in dem Bereich veröffentlicht.

Die drei besonders populären Modelle Chronos, Moirai und TimesFM haben wir in einem anderen Blogbeitrag für Sie verglichen.

Starten Sie jetzt durch:

Wir freuen uns auf den Austausch mit Ihnen.