Data Science, die Extraktion von Wissen aus Daten, ist in vielen Branchen zu einem der entscheidenden Erfolgsfaktoren geworden. Im Zuge der Digitalisierung fangen Unternehmen verstärkt an das Potenzial ihrer Daten zu nutzen. Allerdings ergibt sich aus diesem Ziel eine Reihe neuer Anforderungen und Überschneidungen innerhalb eines Unternehmens, beispielsweise zwischen Fachabteilungen, IT und Data Science Professionals, um aus einer kurzlebigen Erkenntnis einen langfristigen und operationalisierten Nutzen zu generieren.

Die Herausforderungen für Unternehmen

Am Anfang steht für die meisten Unternehmen das Analyse-Ergebnis sowie der jeweilige Use Case im Vordergrund. Solange es um eine einmalige Analyse geht, dessen gesamte Entwicklungsumgebung der Laptop des Analysten ist, kann auf diesem Weg oft ein schneller erster Mehrwert generiert werden.

Nach diesen Erfolgen stellt sich oft ein sukzessives Wachstum der Anforderungen ein. Kommen mehr Analysten zum Einsatz müssen Fragen zum kollaborativen Arbeiten, beispielsweise wie ein Code geteilt und versioniert wird, beantwortet werden. Reichen die Ressourcen eines Laptops durch ein Wachstum an Komplexität und Datenmenge nicht mehr für den Betrieb einer Analyse aus, lohnt sich die Anschaffung eines entsprechenden Servers für die Ausführung, der im Idealfall professionell in die bestehende IT-Landschaft integriert wird. Werden mit der Zeit die Ergebnisse aus Data-Science-Projekten vermehrt als Entscheidungsgrundlage genutzt sollten die zugrunde liegenden Projekte durch sinnvolle, automatisierte Tests gesichert werden, damit nicht jede Analyse einer manuellen Validierung bedarf.

Um diesen Problemen mit einer nachhaltigen Lösung zu begegnen, brauch es ein passgenaues technisches Ökosystem, bei welchem sich verschiedene Systeme, wie z.B. GIT, RStudio und Shiny, gegenseitig beeinflussen. Dieses Ökosystem muss den Rahmenbedingungen und Prozessen der Analysen sowie der Unternehmens-IT gerecht werden. Für dieses Ökosystem sind folgende Voraussetzungen notwendig:

- Die richtigen Produkte

- Die IT-Infrastruktur

- Die Einhaltung der Compliance-Anforderungen

Oftmals werden diese Aspekte nicht ausreichend berücksichtigt – zu sehr steht die kurzfristige Entwicklung der Analysemodelle im Vordergrund. Eine strukturierte und auf die Anforderungen von Analytik abgestimmte Infrastruktur zahlt sich jedoch für alle Beteiligten aus und ist eine wichtige Voraussetzung zur Professionalisierung von Data Science.

Das Zusammenspiel von Data Science und IT

In dem so entstehenden Zusammenspiel zwischen Data Science und IT ist es erforderlich die Interessen beider Parteien zu berücksichtigen und kommunikative Grenzen aufzubrechen.

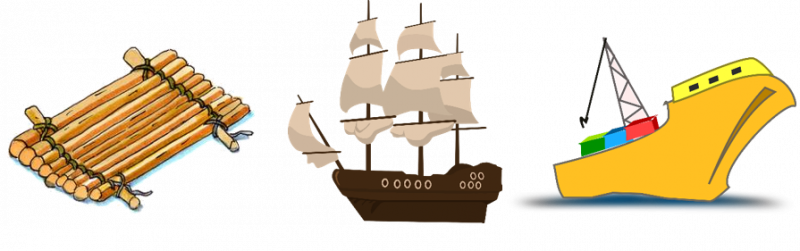

Das Streben von Data Science nach Flexibilität, kreativen Freiräumen und schnellen Lösungsansätzen, in den meisten Fällen auf Basis von Open-Source-Technologien, wünscht bei einem Einsatz möglichst großen Handlungsspielraum. Vergleichbar mit einem Floß, das genau passend für die jeweilige Analyse dimensioniert wurde.

Dem gegenüber steht die IT-Abteilung, die an einem stabilen System und an klaren Prozessen interessiert ist – und dabei die Sicherheit immer im Blick hat. Für jede Auslieferung einer Analyse ein passgenaues System zu pflegen steht hier berechtigtem Interesse nach Standardisierung und Nachhaltigkeit gegenüber. Also dem Wunsch einen Weg, alle Erkenntnisse auf einem klaren Weg ihrer weiteren Nutzung zuzuführen. Vergleichen könnte man dies mit einem Frachtschiff, das viele unterschiedliche Waren befördert.

Diese beiden Seiten gilt es möglichst früh zusammenzubringen, um den Mittelweg zwischen dem flexiblen Floß, Data Science, und dem trägeren, aber stabileren Frachtschiff der IT-Administration zu finden.

Wo stehen die Unternehmen heute?

In unserer täglichen Arbeit, dicht an den relevanten Akteuren und den vorhandenen IT-Infrastrukturen, haben wir es mit ganz unterschiedlichen Entwicklungsstadien zu tun. Einerseits gibt es Unternehmen, die bereits sehr professionelle Prozesse und Strukturen implementiert haben. An dieser Stelle streben Unternehmen nach einer Art Data-Science-Infrastruktur-TÜV, der beispielsweise bestehende Bottlenecks identifiziert und den Feinschliff der Infrastrukturkomponenten adressiert.

Zumeist stehen die Data-Science-Abteilungen aber noch am Anfang. Hier bietet sich die Möglichkeit, mit der Professionalisierung bereits nach den ersten erfolgreichen Data-Science-PoCs (Proof of Concepts) zu beginnen. So kann vermieden werden, dass sich Data-Science- und IT-Abteilung zu sehr voneinander entfernen, was folglich das Konfliktpotential senkt. Zudem können Defizite durch die frühzeitige Einführung von professionellen Systemen vermieden werden.

Architektur, Automatisierung, Dokumentation oder das Rechtemanagement: In den nächsten Monaten werden wir Ihnen auf unserem Blog die einzelnen Komponenten von IT-Infrastrukturen vorstellen, die den Anforderungen im Zeitalter von Big Data und KI standhalten.

Ihr Unternehmen befindet sich gerade in der Einführung datengeschützter Analyseprozesse? Ihr Unternehmen plant eine systematische und zukunftssichere Integration von Data Science Tools? Sie betreiben bereits eine bestehende Umgebung, wünschen sich aber professionelle Unterstützung bei der Abbildung gewachsener Anforderungen? Dann wenden Sie sich an uns! Im Rahmen unseres eoda | analytic infrastructure consultings entwickeln unsere erfahrenen Experten, die für Ihre Rahmenbedingungen optimale Infrastruktur.

Hier entlang.